Det mobile operativsystemet iOS 13 har også en veldig interessant funksjon som lar applikasjoner ta forskjellige bilder fra forskjellige kameraer på samme enhet, inkludert lyd.

Noe lignende har fungert på Mac siden OS X Lion-operativsystemets dager. Men inntil nå har den begrensede ytelsen til mobil maskinvare ikke tillatt dette. Men med den nyeste generasjonen iPhone og iPad faller selv denne hindringen, og iOS 13 kan derfor ta opp samtidig fra flere kameraer på én enhet.

Det kan være interesserer deg

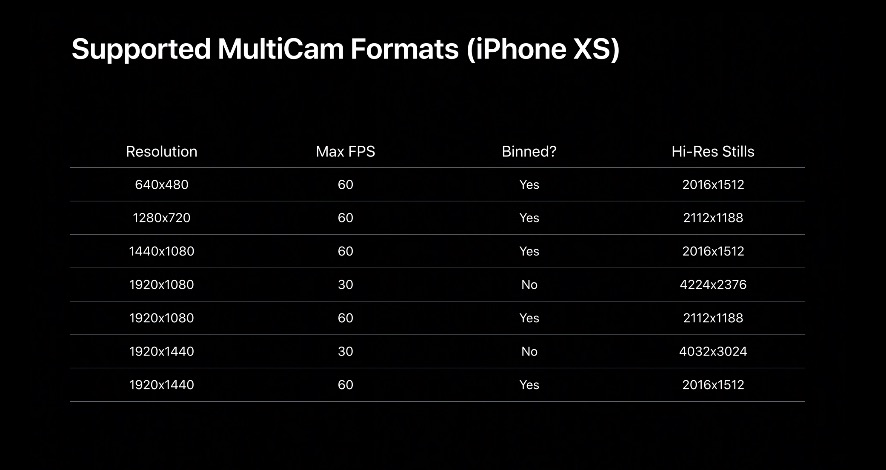

Takket være det nye API-et vil utviklere kunne velge fra hvilket kamera applikasjonen tar hvilken inngang. Med andre ord kan for eksempel frontkameraet ta opp video mens det bakre kameraet tar bilder. Dette gjelder også lyd.

En del av presentasjonen på WWDC 2019 var en demonstrasjon av hvordan en applikasjon kan bruke flere poster. Applikasjonen vil dermed kunne ta opp brukeren og samtidig ta opp bakgrunnen til scenen med bakkameraet.

Samtidig opptak av flere kameraer kun på nye enheter

I Photos-applikasjonen var det da mulig å ganske enkelt bytte begge postene under avspilling. I tillegg vil utviklere få tilgang til TrueDepth-kameraene foran på de nye iPhone-ene eller vidvinkel- eller teleobjektivet på baksiden.

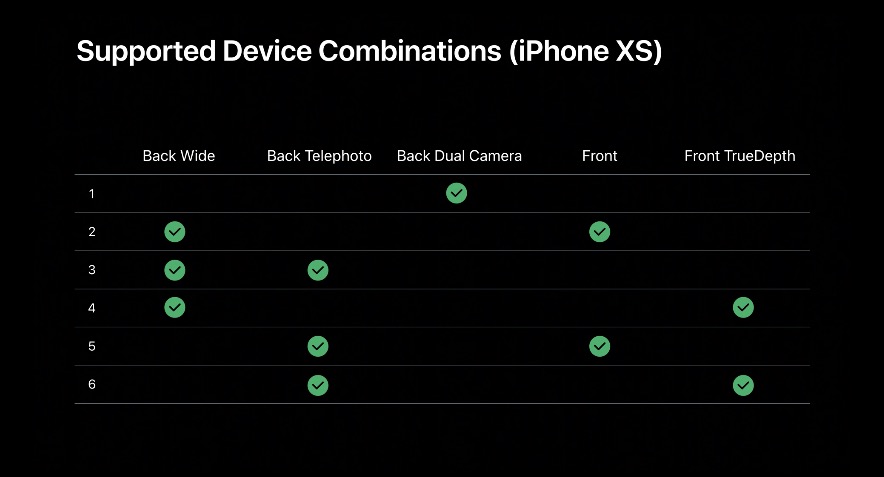

Dette bringer oss til den begrensningen funksjonen vil ha. Foreløpig er det bare iPhone XS, XS Max, XR og den nye iPad Pro som støttes. Ingen andre enheter nye funksjon i iOS 13 de kan ikke bruke det ennå og vil sannsynligvis ikke kunne det heller.

I tillegg har Apple publisert lister over støttede kombinasjoner. Ved nærmere undersøkelse kan det konkluderes med at noen begrensninger ikke er så mye av maskinvarekarakter som av programvarekarakter, og Cupertino blokkerer bevisst tilgang enkelte steder.

På grunn av batterikapasiteten vil iPhone og iPad kun kunne bruke én kanal med opptak fra flere kameraer. Tvert imot, Mac har ingen slik begrensning, ikke engang bærbare MacBook-er. I tillegg vil den omtalte funksjonen sannsynligvis ikke engang være en del av systemkameraappen.

En utviklers fantasi

Hovedrollen vil derfor være utviklernes ferdigheter og deres fantasi. Apple har vist en ting til, og det er den semantiske gjenkjennelsen av bildesegmenter. Ingenting annet er skjult under dette begrepet enn evnen til å gjenkjenne en figur i et bilde, dens hud, hår, tenner og øyne. Takket være disse automatisk oppdagede områdene kan utviklere deretter tilordne ulike deler av koden, og dermed funksjoner.

Det kan være interesserer deg

På WWDC 2019-workshopen ble det presentert en applikasjon som filmet bakgrunnen (sirkus, bakre kamera) parallelt med bevegelsen til karakteren (bruker, frontkamera) og var i stand til å angi fargen på huden som en klovn ved hjelp av semantiske områder .

Så vi kan bare se frem til hvordan utviklerne tar opp den nye funksjonen.

kilde: 9to5Mac