De siste årene har mobiltelefonverdenen sett store endringer. Vi kan se grunnleggende forskjeller i praktisk talt alle aspekter, uansett om vi fokuserer på størrelse eller design, ytelse eller andre smarte funksjoner. Kvaliteten på kameraer spiller for tiden en relativt viktig rolle. For øyeblikket kan vi si at dette er en av de viktigste aspektene ved smarttelefoner, der flaggskipene konstant konkurrerer. Når vi i tillegg sammenligner for eksempel Android-telefoner med Apples iPhone, finner vi en rekke interessante forskjeller.

Det kan være interesserer deg

Hvis du er interessert i en verden av mobilteknologi, så vet du sikkert at en av de største forskjellene kan finnes når det gjelder sensoroppløsning. Mens Androider ofte tilbyr et objektiv med mer enn 50 Mpx, har iPhone satset på kun 12 Mpx i årevis, og kan fortsatt tilby bilder av bedre kvalitet. Imidlertid er det ikke mye oppmerksomhet til bildefokuseringssystemer, der vi møter en ganske interessant forskjell. Konkurrerende telefoner med Android-operativsystemet er ofte (delvis) avhengige av såkalt laser autofokus, mens smarttelefoner med eplelogoen ikke har denne teknologien. Hvordan fungerer det egentlig, hvorfor brukes det og hvilke teknologier er Apple avhengig av?

Laserfokus vs iPhone

Den nevnte laserfokuseringsteknologien fungerer ganske enkelt, og bruken er veldig fornuftig. I dette tilfellet er det skjult en diode i fotomodulen, som sender ut stråling når avtrekkeren trykkes inn. I dette tilfellet sendes det ut en stråle som spretter av det fotograferte motivet/objektet og returnerer, hvilken tid kan brukes til raskt å beregne avstanden gjennom programvarealgoritmer. Dessverre har den også sin mørke side. Når du tar bilder på større avstander, er ikke laserfokuset lenger like nøyaktig, eller når du tar bilder av gjennomsiktige objekter og ugunstige hindringer som ikke kan reflektere strålen pålitelig. Av denne grunn er de fleste telefoner fortsatt avhengige av den aldersbeviste algoritmen for å oppdage scenekontrast. En sensor med slikt kan finne det perfekte bildet. Kombinasjonen fungerer veldig bra og sikrer rask og nøyaktig bildefokusering. For eksempel har den populære Google Pixel 6 dette systemet (LDAF).

På den annen side har vi iPhone, som fungerer litt annerledes. Men i kjernen er det ganske likt. Når avtrekkeren trykkes inn, spiller ISP- eller Image Signal Processor-komponenten, som har blitt betydelig forbedret de siste årene, en nøkkelrolle. Denne brikken kan bruke kontrastmetoden og sofistikerte algoritmer for å umiddelbart vurdere det beste fokuset og ta et bilde av høy kvalitet. Basert på de innhentede dataene er det selvfølgelig nødvendig å mekanisk flytte linsen til ønsket posisjon, men alle kameraer i mobiltelefoner fungerer på samme måte. Selv om de styres av en "motor", er bevegelsen deres ikke roterende, men lineær.

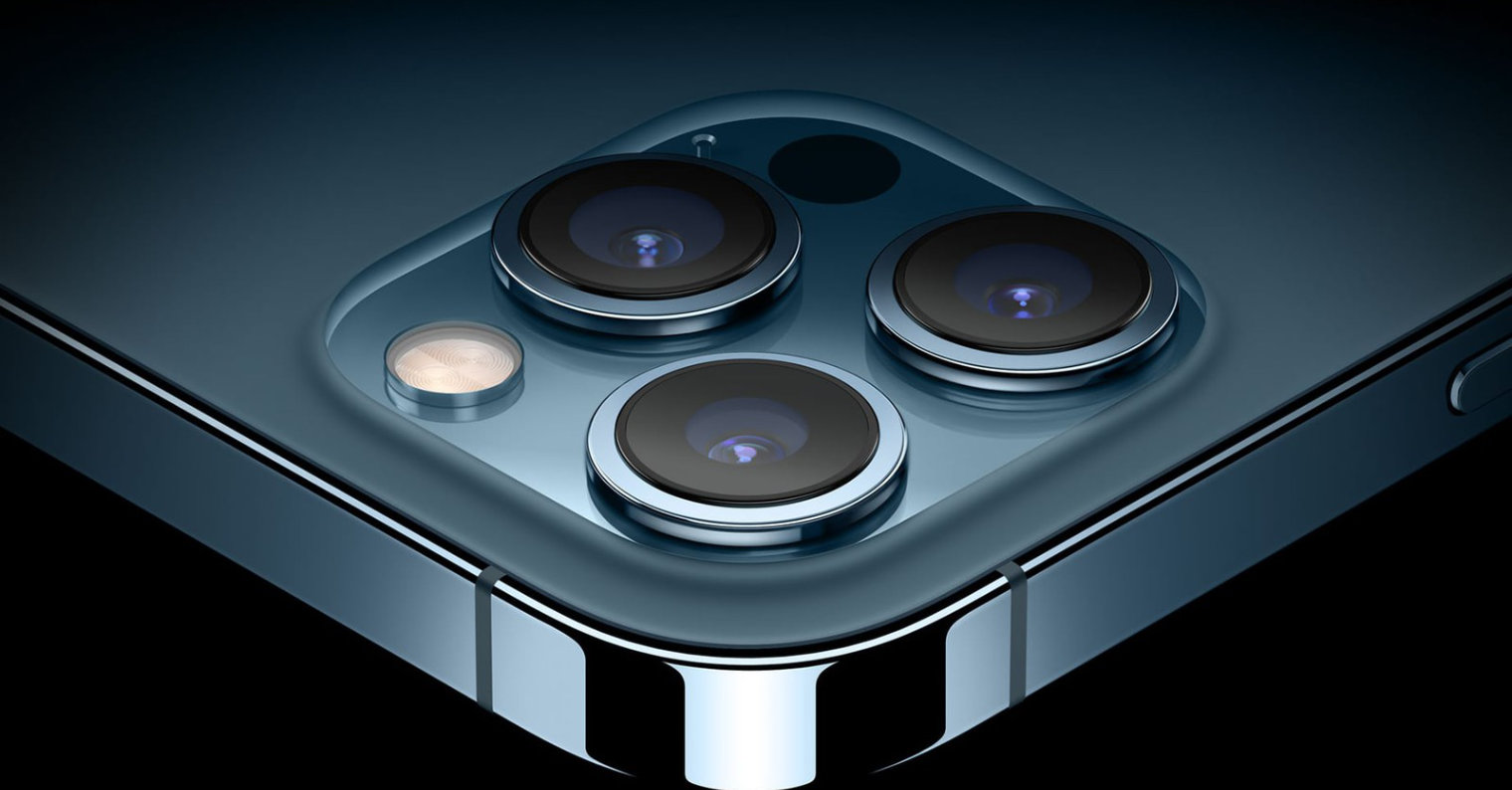

Ett skritt foran er modellene iPhone 12 Pro (Max) og iPhone 13 Pro (Max). Som du kanskje har gjettet, er disse modellene utstyrt med en såkalt LiDAR-skanner, som umiddelbart kan bestemme avstanden fra det fotograferte motivet og bruke denne kunnskapen til sin fordel. Faktisk er denne teknologien nær det nevnte laserfokuset. LiDAR kan bruke laserstråler til å lage en 3D-modell av omgivelsene, og derfor brukes den hovedsakelig til skanning av rom, i autonome kjøretøy og til å ta bilder, først og fremst portretter.

Det kan være interesserer deg

Adam Kos

Adam Kos

Flyr verden rundt med Apple

Flyr verden rundt med Apple